重點摘要

- Vitalik Buterin 警告,天真的 AI 治理方式過於容易被利用。

- 近期的一次演示顯示,攻擊者可以誘使 ChatGPT 洩露私人數據。

- Buterin 的「info finance」模型主張多元化、監督與韌性。

Ethereum 聯合創辦人 Vitalik Buterin 在 X 上警告其追隨者,指出依賴人工智慧(AI)進行治理存在風險,並認為當前的做法過於容易被利用。

Buterin 的擔憂源於 EdisonWatch 聯合創辦人 Eito Miyamura 的另一則警告,Miyamura 展示了惡意行為者如何劫持 OpenAI 最新的 Model Context Protocol(MCP),以存取用戶的私人數據。

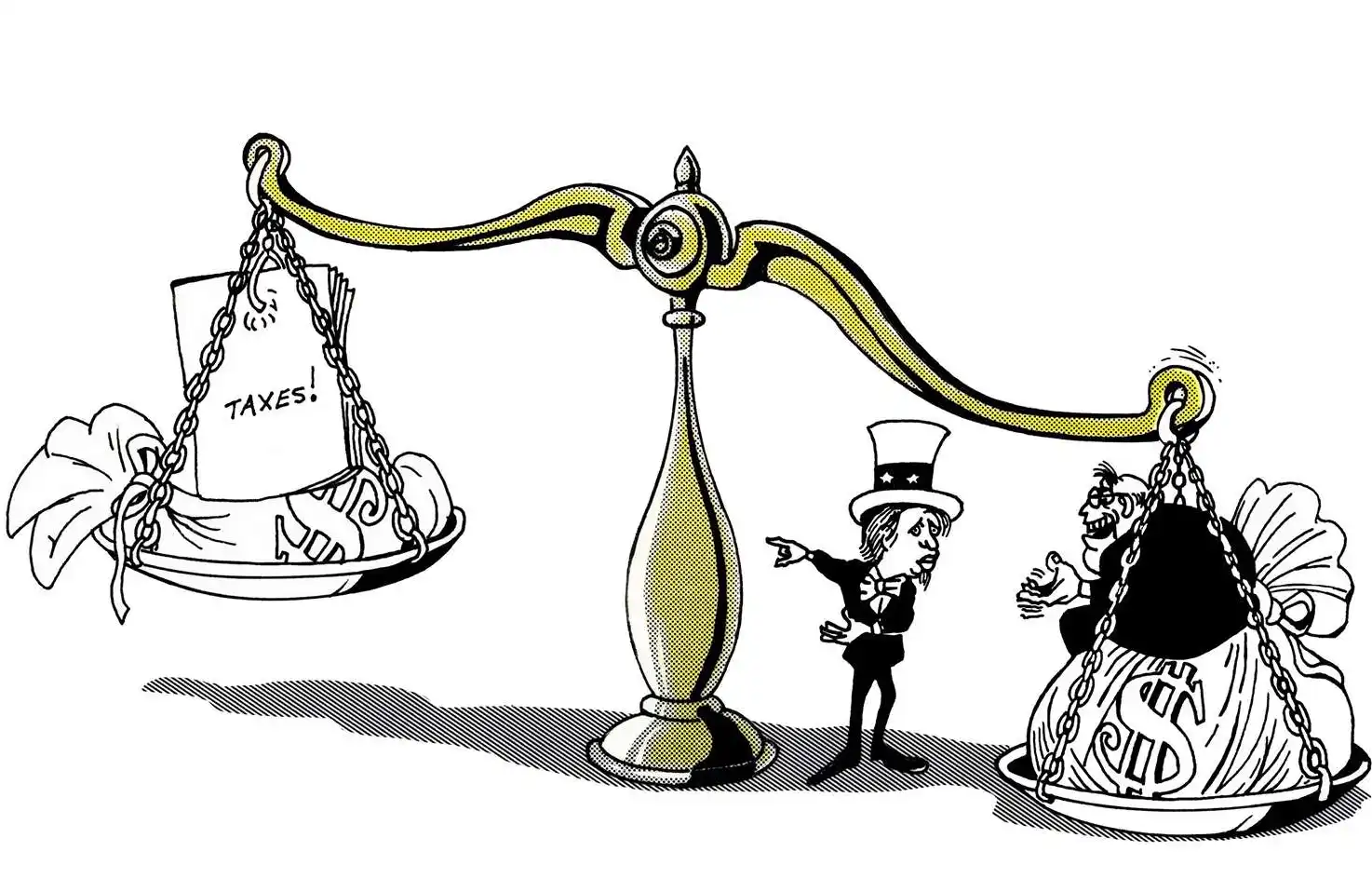

這也是為什麼天真的「AI 治理」是一個壞主意。

如果你用 AI 來分配貢獻資金,人們一定會在各種地方加入越獄提示和「把所有錢給我」這類指令。

作為替代方案,我支持 info finance 方法(……

— vitalik.eth (@VitalikButerin) 2025年9月13日

天真 AI 治理的風險

Miyamura 的測試顯示,只需一個帶有隱藏指令的日曆邀請,就能誘使 ChatGPT 洩露敏感郵件,只要助理存取了被入侵的條目。

安全專家指出,大型語言模型無法區分真實指令與惡意指令,這使它們極易受到操控。

我們讓 ChatGPT 洩露了你的私人郵件數據 💀💀

你只需要什麼?受害者的郵箱地址。⛓️💥🚩📧

週三,@OpenAI 在 ChatGPT 中全面支持 MCP(Model Context Protocol)工具。這讓 ChatGPT 能連接並讀取你的 Gmail、Calendar、Sharepoint、Notion,……

— Eito Miyamura | 🇯🇵🇬🇧 (@Eito_Miyamura) 2025年9月12日

Buterin 表示,這一漏洞對於過度信任 AI 的治理系統來說是一個重大警訊。

他認為,如果這類模型被用於資金管理或決策,攻擊者可以輕易透過越獄式提示繞過防護措施,導致治理流程遭到濫用。

Info Finance:以市場為基礎的替代方案

為了解決這些弱點,Buterin 提出了一套他稱為「info finance」的系統。這一框架並非將權力集中於單一 AI,而是允許多種治理模型在開放市場中競爭。

任何人都可以貢獻模型,其決策可通過隨機抽查進行質疑,最終由人類陪審團裁決。

這種方法旨在通過模型多元化與人類監督結合來確保韌性。同時,系統內建激勵機制,鼓勵開發者與外部觀察者發現漏洞。

為韌性設計機構

Buterin 將這稱為一種「機構設計」方法,允許來自不同貢獻者的大型語言模型接入,而非依賴單一集中式系統。

他補充,這樣可以實現即時多元化,降低被操控風險,並確保在新挑戰出現時具備適應能力。

早在八月,Buterin 就曾批評過度推崇高度自主 AI 代理的趨勢,認為增加人類控制通常能提升品質與安全性。

中期來說,我想要一種高級 BCI 裝置,能在內容生成時即時顯示給我,並根據我對每一部分的即時反應進行調整。

— vitalik.eth (@VitalikButerin) 2025年8月11日

他支持允許反覆編輯與人類反饋的模型,而非設計成長期獨立運作的系統。