比特幣最近的 Op_Return 討論和 Bitcoin Core 節點政策

這一次爭議完全沒有分裂的風險。

作者:黃世亮,閃電HSL

最近比特幣關於 Op_Return 輸出討論非常激烈,又激發了我的好奇心,我決定寫一篇文章總結。其實這樣的文章,主要是寫給自己看,除非特別關心協議和技術,大家沒必要浪費時間讀。

甚至,現在 AI 這麼強了,我覺得讓 chatgpt o3 或者讓 gemini 2.5 pro deep research 給各位寫,要比我寫的好太多。

在前幾天,有一位朋友要做空 Ordi,恰好是 31 位 Core 貢獻者聯合發布《交易轉發政策聲明》的時間後。

我非常想告訴他這些關於 Op_Return 和往 UTXO 裡塞數據的討論,以及潛在的和銘文的關係。

但鑑於我對價格的預測真是爛到家了,我還是沒說,不能影響別人發財啊。而且我真心覺得技術和價格現在是完全脫離了,沒啥關係了。

一直以來,Core 開發組,作為比特幣的「官方」,對往比特幣區塊鏈上塞各種和比特幣作為貨幣屬性無關的數據,都是嚴防死守的。這個政策是從 2014 年 Opreturn 被引入 Bitcoin 開始,一直延續到最近的 31 位 Core 貢獻者聯合聲明之前,都是妥妥的嚴防死守。Core 一直對「非金融數據」抱持最小化立場:1)每筆交易最多 1 個 OPRETURN;2)單條數據不能超過 80 字節;3)允許節點用 -datacarriersize 手動調大,b 也就是這本質上不是共識規則。

一直以來,Core 官方的態度和代碼實踐上都是嚴格限制「非金融」數據上鏈的。

但最近 Bitcoin Core 的代碼倉庫更新了對這些「非金融」數據的態度,一下子放開了對這些數據的限制,而且步子邁的特別大。

Core 開發者 Peter Todd(這哥們現在到處稱自己不是 Core 貢獻者,只是研究者了,哈)在 2025 年 4 月份搞一個 PR #32359 「Remove arbitrary limits on OP_RETURN outputs」,提議:1)

刪除單條 80 字節和「單輸出」檢查;2)廢棄 -datacarriersize 相關選項;3)其餘 DoS 防護交由市場費用 + 帶寬綜合判斷。

需要說明的是這個 PR 尚未合併進 Bitcoin core 主代碼倉庫,但 最近的 31 名開發者的聯合聲明等於給放寬政策「背書」,看起來要合併這個 PR。

另外,在 2021 年 5 月 BCH 的升級是做了類似的規則更新,但這次 BTC 的規則更激進,BCH 到現在為止在代碼層次上還是限制單筆交易的 opreturn 總字節尺寸不能超過 223 字節,在一筆 bch 交易裡可以有多個 opreturn 輸出,但總字節數不能超過 223 字節。

而 BTC 的這次 PR 是沒有對 Opreturn 在單筆交易的總字節量做出限制,但比特幣的單筆交易有 1M 字節的限制,所以也可以認為單筆交易對 Opreturn 的字節限制是 1M。

以上就是這一次 Bitcoin Core 節點軟件在代碼層面上對「非金融數據」上鏈的政策更改。

為什麼會有這一更改?

從銘文在 2022 年火起來後,比特幣區塊鏈的總數據量(節點軟件需要下載的文件總量)以及 UTXO 數量(節點軟件裡必須常駐內存的數據)都大規模膨脹。

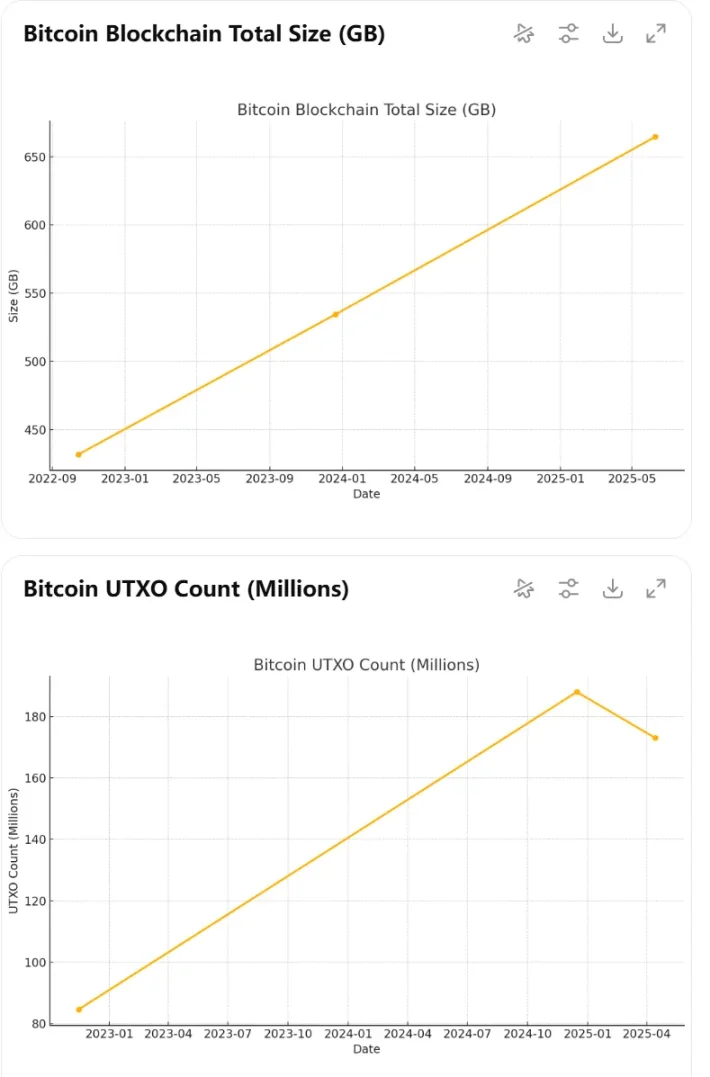

下面是我使用 chatgpt o3 模型調研數據,並畫出來的銘文火起來後比特幣區塊鏈數據膨脹的歷史。

區塊鏈總數據量從 ≈ 430 GB(2022-10)膨脹到 ≈ 665 GB(2025-06);

UTXO 集合一度衝到 1.88 億條(2024-12),是 2022 年的兩倍多;

(OP_RETURN 本身不進 UTXO,但碎片化 Taproot 輸出會顯著拉高。)

讓比特幣鏈上「胖身材 + 多碎片」同時出現,磁碟胀 60%、UTXO 翻 2 倍,這讓很多開發者擔心去中心化的成本了。

Core 開發組從 2022 年以來,對銘文這些的應用就抱有非常大的敵意,強烈要求在規則層面進一步限制這些數據。Core 開發者的主流觀點是比特幣區塊鏈要去中心化,就要限制這些非金融數據,以讓節點運行成本不會膨脹。

這裡以 Lukejr 為代表,Lukejr 自己開發的節點軟件 Knots 就直接限制了對將數據塞進 op_return 的銘文類應用的交易的中繼,就是 Knote 作為比特幣的節點軟件在收到銘文交易後是不轉發的。

Op_return 本身在比特幣規則裡是可以被節點軟件裁剪的,也就是不具備區塊鏈常見的數據永久保存的能力。

很多其他銘文類的應用,就擔心自己的數據被比特幣規則限制,使用了各種 hack 手段來設計協議,從利用 Op_return,進化到了將數據塞進 taproot 腳本裡,保存在交易的見證數據(witness)裡。

在見證數據裡,受益於 segwit 的手續費打折,以及見證數據區塊的 3M 上限,讓這些銘文類數據的礦工費又便宜,設計起來還比 op_return 還簡單,並且受比特幣協議保護,不會被裁剪。

這下就更惹火了 Core 開發組的很多開發者。

但除了少部分 Core 開發者,好像整個生態都挺歡迎這些銘文類應用的,包括礦工和交易所,都是明牌支持。

交易大量上架各種銘文類代幣。

礦工甚至大量打包非標準腳本交易,以配合很多銘文類協議產生的更大更複雜的交易,這在實事上就突破了 op_return 數據的限制,因為本質上這種限制並不是共識層面的限制,只要有礦池打包了,其它礦池不會拒絕的。

上述兩種情況,對比特幣區塊鏈數據的影響的區別是很大的。Opreturn 類數據和 taproot 腳本都會顯著增加區塊數據量,也會大量增加 UTXO 的數量。然而在完整節點運營視角來看,Opreturn 數據是可裁減的,但 taproot 腳本是不可裁減的。

這樣的局勢發展,大約是到了要倒逼協議做出變更了。

如果銘文類應用無法阻擋,那在協議層如果放開對 Opreturn 數據的限制,給銘文類應用放開一個口子,引導它們使用 Opreturn,而不是 taproot 腳本,或許對比特幣的節點運營來說是更友好的。

就讓 Core 開發者產生了兩派,少量的堅定認為應該在協議層堵死銘文類應用產生的「垃圾數據」,他們堅定認為銘文類應用就是對比特幣發動的 DDOS。

而更多的開發者是覺得兩權相害取其輕,引導數據往 op_return 發展,而不是可花費的腳本。

這就是,目前我看到的情況。

我覺得目前局勢發展下去會產生什麼結果呢?

對 Op_return 數據的協議層更改,並不會產生比特幣鏈的分裂,這是非共識層的。而且目前像 Luke jr 這樣的強烈反對「非金融數據」上鏈的一方,採取的最極端的做法也僅僅是限制節點對銘文類交易的中繼,而不是直接在協議裡做設定其為非法。

所以這一次爭議完全沒有分裂的風險。

但我覺得 Bitcoin core 節點軟件會朝著放寬 Op_return 數據限制方向發展。Luke jr 這一派估計是要認了,按我讀到的文章,Luke jr 可是堅定的鬥士,對自己的理念極其堅定,但這一次我覺得 Luke jr 要麼做好長期戰鬥準備,要麼認了。

銘文類,二層類應用,可能會迎來更友好的比特幣底層協議開發環境。

但我對價格,是真不知道。

免責聲明:文章中的所有內容僅代表作者的觀點,與本平台無關。用戶不應以本文作為投資決策的參考。

您也可能喜歡

BGB 持幣群組聖誕迎春狂歡季,買入 1 BGB 贏取 2026 BGB 節日大獎

交易俱樂部爭霸賽(第 20 期)- 單人最高獨享 2,400 BGB 獎勵,還有 RHEA 獎池、盲盒獎池等您來戰

ETH 理財雙重獎勵,VIP 專屬福利!最高 8% APR + 瓜分 30,000 USDT

Bitget現貨杠桿關於暫停 ICNT/USDT, PROMPT/USDT, CAMP/USDT, FARTCOIN/USDT, PEAQ/USDT 杠桿交易服務的公告