AI“下沉”之后,才是Web3大显身手的时候?

作者:Haotian

最近观察 AI 行业,发现个越来越「下沉」的变化:从原先拼算力集中和「大」模型的主流共识中,演变出了一条偏向本地小模型和边缘计算的分支。

这一点,从 Apple Intelligence 覆盖 5 亿设备,到微软推出 Windows 11 专用 3.3 亿参数小模型 Mu,再到谷歌 DeepMind 的机器人「脱网」操作等等都能看出来。

会有啥不同呢?云端 AI 拼的是参数规模和训练数据,烧钱能力是核心竞争力;本地 AI 拼的是工程优化和场景适配,在保护隐私、可靠性和实用性上会更进一步。(主要通用模型的幻觉问题会严重影响垂类场景渗透)

这其实对 web3 AI 会有更大的机会,原来大家拼「通用化」(计算、数据、算法)能力时自然被传统 Giant 大厂垄断,套上去中心化的概念就想和谷歌、AWS、OpenAI 等竞争简直痴人说梦,毕竟没有资源优势、技术优势,也更没有用户基础。

但到了本地化模型 + 边缘计算的世界,区块链技术服务面临的形势可就大为不同了。

当 AI 模型运行在用户设备上时,如何证明输出结果没有被篡改?如何在保护隐私的前提下实现模型协作?这些问题恰恰是区块链技术的强项...

有注意到一些 web3 AI 相关新项目,诸如最近由 Pantera 零投 10M 的@Gradient_HQ推出的数据通信协议 Lattica,来解决中心化 AI 平台的数据垄断和黑箱问题;@PublicAI_脑电波设备 HeadCap采集真实人类数据,构建「人工验证层」,已经实现了 14M 的收入;其实,都在尝试解决本地 AI 的「可信性」问题。

一句话:只有当 AI 真正「下沉」到每个设备时,去中心化协作才会从概念变成刚需?

#Web3AI 项目与其继续在通用化赛道里内卷,不如认真思考怎么为本地化 AI 浪潮提供基础设施支持?

免责声明:文章中的所有内容仅代表作者的观点,与本平台无关。用户不应以本文作为投资决策的参考。

你也可能喜欢

UNI销毁提案投票、Lighter TGE预期,海外币圈今天在聊啥?

干掉 OpenAI ?开源 AI 平台 Sentient 的野心不止于此

Bitget 每日早报(12月19日)|美联储维持4.25%-4.50%区间利率不变;约230亿美元的比特币期权将于下周五到期,或加剧已高企的波动性

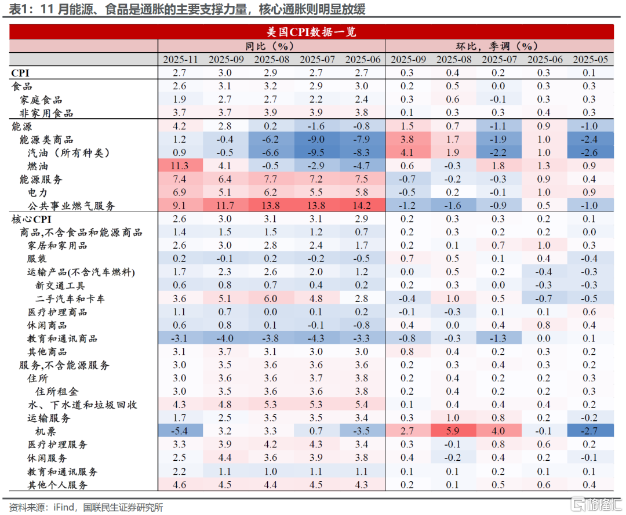

美国CPI爆冷,鸽派迎来转机?