La guerre du DA touche-t-elle à sa fin ? Décryptage de PeerDAS : comment peut-il aider Ethereum à reprendre sa « souveraineté des données »

Rédigé par : imToken

À la fin de l'année 2025, la communauté Ethereum a accueilli relativement calmement la conclusion de la mise à niveau Fusaka.

En regardant l'année écoulée, bien que les discussions sur les mises à niveau techniques de base aient progressivement disparu des projecteurs du marché, de nombreux utilisateurs on-chain ont sans doute déjà ressenti un changement significatif : les L2 d'Ethereum sont devenus de plus en plus abordables.

Aujourd'hui, pour les interactions on-chain, qu'il s'agisse de transferts ou d'opérations DeFi complexes, les frais de Gas ne coûtent souvent que quelques centimes, voire sont négligeables. Derrière cela, la mise à niveau Dencun et le mécanisme Blob ont bien sûr joué un rôle clé. Parallèlement, avec l'activation officielle de la fonctionnalité centrale PeerDAS (Peer Data Availability Sampling, échantillonnage de la disponibilité des données en peer-to-peer) lors de la mise à niveau Fusaka, Ethereum est également en train de tourner définitivement la page de l'ère de la vérification des données par « téléchargement complet ».

On peut dire que ce qui déterminera réellement si Ethereum peut supporter à long terme et de manière durable des applications à grande échelle, ce n'est pas seulement le Blob en lui-même, mais surtout l'étape suivante représentée par PeerDAS.

I. Qu'est-ce que PeerDAS ?

Pour comprendre la signification révolutionnaire de PeerDAS, il ne suffit pas d'en parler en théorie, il faut d'abord revenir sur une étape clé de la scalabilité d'Ethereum, à savoir la mise à niveau Dencun de mars 2024.

À ce moment-là, l'EIP-4844 a introduit un modèle de transaction embarquant des Blobs (intégrant une grande quantité de données de transaction dans des blobs), permettant ainsi aux L2 de ne plus dépendre du coûteux mécanisme de stockage calldata, mais d'utiliser à la place le stockage temporaire des Blobs.

Ce changement a directement réduit le coût des Rollups à une fraction de ce qu'il était auparavant, garantissant que les plateformes L2 puissent offrir des transactions moins chères et plus rapides, sans compromettre la sécurité et la décentralisation basées sur Ethereum, et a permis aux utilisateurs de profiter de l'ère des « faibles frais de Gas ».

Cependant, bien que les Blobs soient très pratiques, le nombre de Blobs que le réseau principal Ethereum peut contenir par bloc est limité (généralement 3 à 6), pour une raison très concrète : la bande passante physique et l'espace disque sont limités.

Dans le modèle de validation traditionnel, chaque validateur du réseau, qu'il s'agisse de serveurs exploités par des institutions professionnelles ou d'ordinateurs domestiques d'investisseurs particuliers, doit toujours télécharger et propager l'intégralité des données Blob pour pouvoir valider leur validité.

Cela pose un dilemme :

- Si l'on augmente le nombre de Blobs (pour la scalabilité) : le volume de données explose, la bande passante des nœuds domestiques est saturée, les disques durs sont pleins, ce qui les force à se déconnecter, et le réseau se centralise rapidement, devenant une blockchain réservée aux grands data centers ;

- Si l'on limite le nombre de Blobs (pour la décentralisation) : le débit des L2 est plafonné, incapable de répondre à une croissance explosive de la demande à l'avenir.

En d'autres termes, le Blob n'est qu'une première étape, résolvant la question de « où stocker » les données. Tant que le volume de données reste faible, tout va bien, mais si le nombre de Rollups continue d'augmenter et que chacun soumet des données à haute fréquence, la capacité des Blobs s'accroît sans cesse, alors la pression sur la bande passante et le stockage des nœuds deviendra un nouveau risque de centralisation.

Si l'on continue à utiliser le modèle traditionnel de téléchargement complet, sans résoudre la pression sur la bande passante, la route de la scalabilité d'Ethereum se heurtera à un mur physique. PeerDAS est précisément la clé pour dénouer ce nœud.

Pour résumer en une phrase, PeerDAS est essentiellement une toute nouvelle architecture de validation des données, qui brise la règle selon laquelle la validation nécessite un téléchargement complet, permettant ainsi l'expansion des Blobs au-delà des limites actuelles de la bande passante physique (par exemple, passer de 6 Blobs/bloc à 48 ou plus).

II. Le Blob résout « où stocker », PeerDAS résout « comment stocker »

Comme mentionné ci-dessus, le Blob a franchi la première étape de la scalabilité, résolvant la question de « où stocker » les données (en passant du coûteux Calldata à l'espace temporaire des Blobs), tandis que PeerDAS vise à résoudre la question de « comment stocker plus efficacement ».

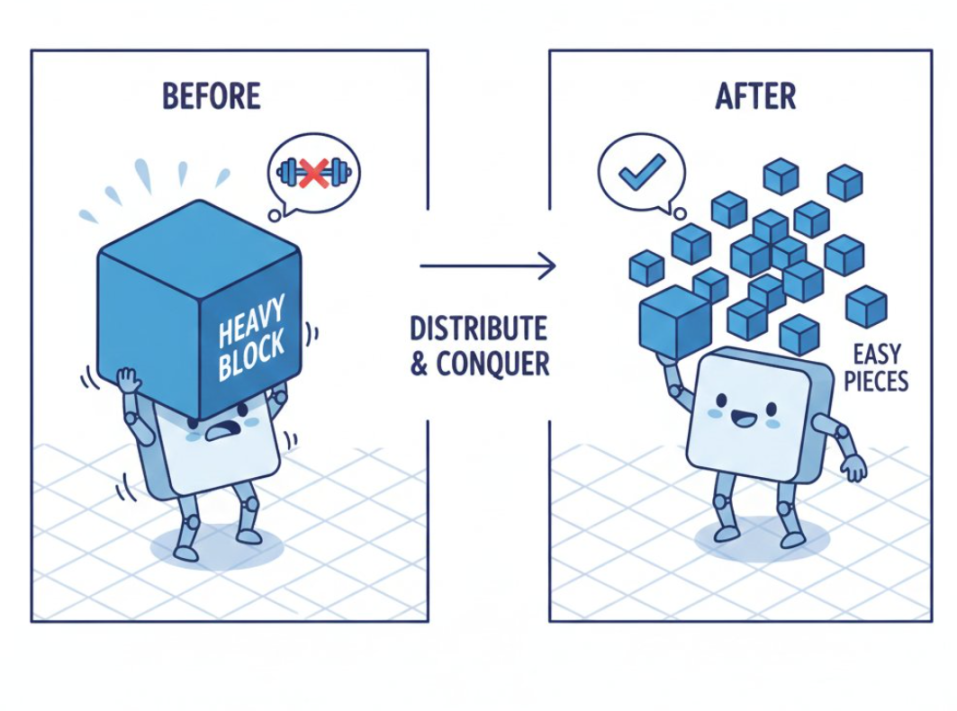

Le problème central à résoudre est le suivant : comment, alors que le volume de données explose de façon exponentielle, éviter d'écraser la bande passante physique des nœuds ? La solution est simple : grâce à la probabilité et à la collaboration distribuée, « il n'est pas nécessaire que chacun stocke toutes les données pour pouvoir confirmer avec une forte probabilité que ces données existent réellement ».

Le nom complet de PeerDAS, « Peer Data Availability Sampling », donne déjà un indice sur cette approche.

Ce concept peut sembler obscur, mais on peut l'illustrer par une métaphore simple : auparavant, la validation complète revenait à ce que, lorsqu'une bibliothèque recevait une encyclopédie Britannica de plusieurs milliers de pages (données Blob), chaque administrateur (nœud) devait en faire une copie complète pour éviter toute perte.

Cela signifiait que seuls ceux qui avaient suffisamment d'argent et de temps (grande bande passante / gros disque dur) pouvaient être administrateurs, d'autant plus que cette encyclopédie (données Blob) ne cessait de s'agrandir. À terme, les gens ordinaires étaient éliminés et la décentralisation disparaissait.

Aujourd'hui, grâce à l'échantillonnage PeerDAS et à des technologies comme le codage d'effacement (Erasure Coding), il est possible de découper ce livre en une multitude de fragments, puis de les étendre mathématiquement. Chaque administrateur n'a plus besoin de posséder le livre entier, il lui suffit d'en conserver quelques pages choisies au hasard.

Lors de la validation, il n'est pas nécessaire que quiconque présente le livre complet ; en théorie, il suffit que le réseau réunisse n'importe quels 50 % des fragments (peu importe si chacun détient la page 10 ou la page 100), et grâce à un algorithme mathématique, on peut reconstituer instantanément et avec une certitude de 100 % l'intégralité du livre.

C'est là toute la magie de PeerDAS — il décharge le fardeau du téléchargement des données d'un seul nœud pour le répartir sur un réseau collaboratif de milliers de nœuds à travers le monde.

Source : @Maaztwts

Source : @Maaztwts

Du point de vue des données, avant la mise à niveau Fusaka, le nombre de Blobs était strictement limité à un chiffre (3-6). Avec la mise en œuvre de PeerDAS, cette limite est directement levée, permettant de passer de 6 à 48 Blobs, voire plus.

Lorsque les utilisateurs effectuent une transaction sur Arbitrum ou Optimism et que les données sont renvoyées au réseau principal, il n'est plus nécessaire de diffuser l'intégralité du paquet de données sur tout le réseau, ce qui permet à Ethereum de réaliser une scalabilité sans augmentation linéaire du coût des nœuds.

Objectivement, Blob + PeerDAS constituent la solution complète de DA (Data Availability). D'un point de vue roadmap, c'est aussi la transition clé d'Ethereum du Proto-Danksharding vers le Danksharding complet.

III. La nouvelle normalité on-chain après Fusaka

Comme chacun le sait, ces deux dernières années, des couches DA modulaires tierces comme Celestia ont connu un énorme essor en raison du coût élevé du réseau principal Ethereum. Leur récit reposait sur un postulat : le stockage natif des données sur Ethereum est très cher.

Mais avec les Blobs et le tout récent PeerDAS, Ethereum est désormais à la fois bon marché et extrêmement sécurisé : le coût pour les L2 de publier des données sur L1 a été réduit de plus de moitié, et Ethereum dispose du plus grand ensemble de validateurs du réseau, offrant une sécurité bien supérieure à celle des chaînes tierces.

Objectivement, cela constitue un coup dur pour des solutions DA tierces comme Celestia, marquant la reprise par Ethereum de la souveraineté sur la disponibilité des données et réduisant considérablement leur espace de survie.

Vous pourriez vous demander : tout cela semble très technique, mais quel rapport avec mon utilisation de portefeuilles, de transferts ou de DeFi ?

Le lien est en fait très direct. Si PeerDAS est déployé avec succès, cela signifie que le coût des données pour les L2 pourra rester bas à long terme, que les Rollups ne seront pas obligés d'augmenter leurs frais en raison d'une hausse des coûts de DA, que les applications on-chain pourront concevoir des interactions à haute fréquence sans crainte, et que les portefeuilles et DApps n'auront plus à faire de compromis entre « fonctionnalités et coûts »...

En d'autres termes, si nous pouvons aujourd'hui profiter de L2 bon marché, c'est grâce aux Blobs ; si nous pouvons continuer à en profiter à l'avenir, ce sera grâce à la contribution discrète de PeerDAS.

C'est pourquoi, dans la feuille de route de la scalabilité d'Ethereum, PeerDAS, bien que discret, est toujours considéré comme une étape incontournable. Fondamentalement, c'est aussi, selon moi, la meilleure forme de technologie — « bénéficier sans s'en rendre compte, mais difficile de s'en passer si elle disparaît », vous ne sentez même pas sa présence.

En fin de compte, PeerDAS prouve que la blockchain peut, grâce à une conception mathématique ingénieuse (comme l'échantillonnage de données), supporter des volumes de données de niveau Web2 sans sacrifier excessivement la vision de la décentralisation.

Ainsi, l'autoroute des données d'Ethereum est désormais complètement construite ; il ne reste plus qu'à voir quels véhicules circuleront dessus, une question à laquelle la couche applicative devra répondre.

Attendons de voir.

Avertissement : le contenu de cet article reflète uniquement le point de vue de l'auteur et ne représente en aucun cas la plateforme. Cet article n'est pas destiné à servir de référence pour prendre des décisions d'investissement.

Vous pourriez également aimer

Uniswap vote sur la destruction de 100 millions de UNI et une nouvelle proposition de changement de frais

En vogue

PlusAptos propose une technologie révolutionnaire de signature résistante aux ordinateurs quantiques pour renforcer la sécurité de la blockchain

Prévision de prix hyper de Bitcoin : la FDIC agit sur le GENIUS Act tandis que DeepSnitch AI offre aux investisseurs particuliers une voie supérieure vers la richesse en 2026