Lors d’un test de simulation, les agents IA d’Anthropic ont découvert une faille de 4,6 millions de dollars dans un smart contract.

Selon ChainCatcher, les dernières recherches d'Anthropic montrent que les AI Agents possèdent des capacités d'attaque on-chain considérables : lors de tests de simulation sur des smart contracts réellement piratés entre 2020 et 2025, Claude Opus 4.5, Sonnet 4.5 et GPT-5 ont reproduit des exploits de failles d'une valeur totale d'environ 4,6 millions de dollars ; lors de l'analyse de 2849 contrats sans vulnérabilités connues, deux modèles ont également découvert deux nouvelles failles zero-day et ont réussi à simuler des profits.

L'étude indique que les gains des attaques on-chain par l'IA ont doublé environ tous les 1,3 mois au cours de l'année écoulée, et que la technologie est désormais pleinement capable d'exploiter des failles de manière autonome et rentable.

Avertissement : le contenu de cet article reflète uniquement le point de vue de l'auteur et ne représente en aucun cas la plateforme. Cet article n'est pas destiné à servir de référence pour prendre des décisions d'investissement.

Vous pourriez également aimer

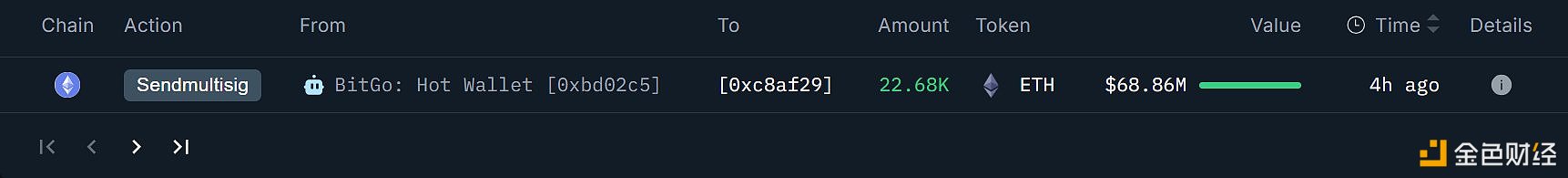

L'adresse supposée de BitMine a de nouveau accumulé 22 676 ETH il y a 4 heures.